Intelligenza Artificiale e gender: stereotipi, discriminazioni e possibili soluzioni

Pubblicato il 22 febbraio 2022

La tecnologia migliora la qualità della vita? Esiste una correlazione tra felicità e tecnologia?

Dallo scorso novembre fino al prossimo 6 giugno, al Futures Festival organizzato dallo Smithsonian Institute, evento in cui è possibile ammirare le innovazioni che sono destinate a cambiare il mondo, possiamo ascoltare una voce molto speciale: Q.

Introdotta nel 2019 come prima voce virtuale senza genere, Q è stata creata per essere utilizzata dai virtual assistant al fine di suscitare un dibattito sul gender nell'Intelligenza Artificialie

Infatti, come afferma Ryan Sherman, uno dei co-creatori del progetto: "Q è stato ideata per avviare una conversazione tra gli addetti ai lavori e il pubblico sul motivo per cui la tecnologia dell'Intelligenza Artificiale - di natura senza genere - sia stata genderizzata". Per progettare Q un team di linguisti, ingegneri del suono e creativi ha collaborato con individui non binari campionandone le voci, per arrivare a creare una gamma sonora unica né femminile, né maschile.

Il gender nell'Intelligenza Artificiale favorisce stereotipi e discriminazioni?

Quando Q era stata annunciata diversi anni fa, è stata salutata come "la voce digitale senza genere di cui il mondo ha bisogno in questo momento", riconoscendo il potenziale danno che i virtual assistant di oggi, nel loro essere per antonomasia femminili, perpetuano nel proporre stereotipi misogini, rappresentando le donne come esecutrici prive di autonomia decisionale.

Il progetto Q ha ottenuto evidenza e riconoscimento in un rapporto delle Nazioni Unite sulle divisioni di genere nelle competenze digitali. "Quasi tutti gli assistenti sono stati femminilizzati nel nome, nella voce, nei modelli e nella personalità." si può leggere in questo rapporto intitolato Arrossirei Se Potessi, ovvero la risposta che Siri originariamente forniva agli utenti che la apostrofano con epiteti volgari o sessisti.

Il contesto odierno: come sta cambiando il rapporto con gli assistenti virtuali

Oggi la situazione sta fortunatamente cambiando: all'inizio del 2020 Apple ha eliminato l’opzione predefinita "femminile" per Siri, e permette ora di scegliere una voce maschile tra un insieme di voci denominate 1, 2, 3 e 4 (in Italia sono 1 e 2). Solo a fine febbraio 2022 Apple ha aggiunto un ulteriore voce, la numero 5: questa, ha affermato l'azienda, è stata registrata da un membro della comunità LGBTQ+ e suona molto più gender-neutral. Teniamo presente, ovviamente, che questo genere di aggiornamenti molto spesso non sono distribuiti allo stesso modo e contemporaneamente in tutto il mondo, quindi di fatto anche oggi lo scenario è differente da Paese a Paese.

Ma per superare gli stereotipi di genere occorre fare ben di più che aggiungere semplicemente un timbro vocale maschile o neutro. Infatti, anche l'idea di una voce "senza genere" rivela alcune delle idee sbagliate che ancora affrontiamo quando pensiamo a modi per evitare di rafforzare gli stereotipi stessi.

Tornando a Q, ad esempio, il suo utilizzo potrebbe rafforzare lo stereotipo che individui non binari non siano né uomini né donne, ma “qualcosa nel mezzo” anziché “al di fuori di esso”. Non si tratta infatti di lottare per la "neutralità" quanto più che altro iniziare ad affrontare ragionamenti ben più profondi, che passano dalle radici stesse della costruzione della relazione tra esseri umani e digitali

Un passo in avanti in questa direzione è stato fatto da Yolande Strengers, professore associato presso la Monash University e coautore, con Jenny Kennedy, di The Smart Wife: Why Siri and Alexa Need a Feminist Reboot.

In questo testo gli autori affermano di non pensare che la soluzione sia rimuovere del tutto il genere dall'equazione dell'Intelligenza Artificiale, perché "questo semplifica eccessivamente il modo in cui questi dispositivi trattano il genere, che non riguarda solo la voce, ma anche il tipo di cose che dicono, la loro personalità, la loro forma e il loro scopo".

Queering: una soluzione possibile al problema

Quindi Y.Strangers e J.Kennedy propongono di “queerizzare la moglie intelligente”. Cosa significa?

Queering the smart wife significa offrire agli assistenti virtuali diverse personalità che rappresentino in modo più accurato le molte versioni della femminilità e della mascolinità che esistono in tutto il mondo, in contrapposizione alla personalità piacevole e servile che molte aziende hanno scelto di adottare per i propri assistenti.

Un esempio potrebbe essere Jibo, un robot introdotto nel 2017 che utilizza pronomi maschili ed è stato commercializzato come robot sociale per la casa. Jibo è caratterizzato da una mascolinità "dolce ed effeminata": ad esempio, Jibo risponde alle domande in modo educato, con uno sguardo civettuolo, e spesso ruota e si avvicina alle persone in modo stravagante.

Queerizzare gli assistenti virtuali può anche significare combattere gli stereotipi con ironia. È il caso di Eno, il bot della banca Capital One, lanciato nel 2019 che, se viene interrogato sul suo genere, risponde scherzosamente: "Sono binario. Non voglio dire che sono entrambe le cose, voglio dire che in realtà sono solo uno e zero".

“Un bot è un bot è un bot”: fornire un gender specifico all'Intelligenza Artificiale

Un altro approccio, forse più coraggioso, è quello di Kai, un chatbot di banking online sviluppato da Kasisto, un'organizzazione che costruisce software di Intelligenza Artificiale per l'online banking. Kai abbandona del tutto le caratteristiche umane, e assume piuttosto un'identità specifica del robot.

Quando gli viene chiesto se è una persona reale, Kai risponde: "Un bot è un bot è un bot. Prossima domanda, per favore", indicando così agli utenti la sua non umanità, neanche pretesa, dato anche il no-sense della risposta in sé.

Anche per questo Jacqueline Feldman - la creatrice del bot - ha affermato di aver progettato Kai affinché fosse in grado di deviare e fermare le molestie. Ad esempio, se un utente molesta ripetutamente il bot, questo risponde con una frase, del tipo, "Sto immaginando sabbia bianca e un'amaca, per favore prova più tardi!".

Questo esempio solleva poi un altro problema dei bot umanizzati. Secondo la Feldman, quando le aziende che progettano bot li rendono troppo umani, rendendo agli utenti difficile comprendere se si sta parlando con una macchina o una persona, si viene a creare un punto di attrito con le esperienze spesso frustranti che i bot stessi offrono. In poche parole, se si sta pensando di star parlando con un umano, e l’esperienza non è all’altezza, si genera inevitabilmente una reazione negativa nell’utente.

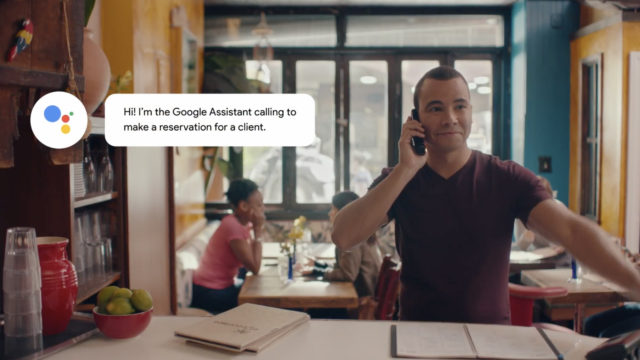

Un caso a questo riguardo è quello riguardante Google Duplex, una tecnologia ora integrata in Google Assistant, che imita straordinariamente la voce umana per eseguire attività come effettuare prenotazioni di ristoranti o fissare un appuntamento per ottenere un taglio di capelli.

Questa tecnologia è stata spesso definita fuorviante per l’utente: per questo nel 2019 la California è diventata il primo stato a richiedere ai bot di identificarsi come tali e, sebbene la legge sia stata descritta come imperfetta, si può certamente definire come primo passo di un nuovo percorso nell’ambito delle norme che regolano le relazioni comunicative.

Conclusioni

Per ridefinire il futuro del rapporto tra assistenti digitali e esseri umani, le aziende e la società devono essere disposti ad affrontare riflessioni profonde, con impatti significativi in vari ambiti lavorativi e privati.

Riflessioni che anche noi di Neosperience stiamo portando avanti riguardo all'identità del nostro assistente virtuale, Sofia. Sebbene abbia un nome femminile, nello sceglierlo siamo stati guidati dalla volontà di rimandare alla Σοφία, la saggezza, nella sua accezione antica, che deriva dall’aggettivo saphés (“chiaro”, “manifesto”, “evidente”, “vero”). Sofia la saggia e la vera, quindi.

Sofia inoltre è completamente personalizzabile, nell’aspetto e nella personalità. Può assumere qualsiasi genere e stile comunicativo, a seconda dei desideri e delle necessità di utenti e clienti. Inoltre, sebbene l’avatar virtuale sia estremamente convincente, la voce è resa volutamente più meccanica rispetto ad altri assistenti virtuali, per non rischiare di ingannare l’interlocutore sulla reale natura di Sofia.

Ma il nostro intento è quello di continuare ad evolvere Sofia, affinché sia adatto a essere utilizzato da tutti sempre, senza mettere in difficoltà o creare un danno alla sensibilità delle persone.

Solo grazie all’eterogeneità e all’approccio di realtà che si occupano di sviluppare un'Intelligenza Artificiale evoluta saremo in grado di portare avanti sviluppi digitali davvero inclusivi, a partire da una corretta rappresentazione del gender.

Il progresso giunge solo dall’accettazione e valorizzazione delle differenze, e il campo tecnologico non fa eccezione.

contenuti simili

Insieme per sconfiggere il Covid-19 grazie all’AI. Scopri l'iniziativa Defeatcovid19.org

L’Intelligenza Artificiale e il Machine Learning possono offrire un aiuto concreto contro il Coronavirus (Covid-19)....

Tecnologia Senziente. Emozioni a misura di sensori

Per Tecnologia Senziente intendiamo le applicazioni della tecnologia che hanno la possibilità di leggere, interpretare...